架起自然語言與視覺之間的橋梁一直是計算機視覺和多媒體領域追求的目標�。這一領域早起探索的任務是對圖片進行描述��,也就是生成單個句子描述圖片內(nèi)容�。近年來的工作則更多關注于對圖片和短視頻內(nèi)容進行更為詳盡的描述��,生成包含多個句子的段落�����。同時����,研究者們也探索了根據(jù)照片流來講述故事���。

不過,人們在記錄人生中重要的事件時�,相比于短的視頻片段,往往更喜歡使用長視頻����,比如生日派對和婚禮。為此�����,來自新加坡國立大學與明尼蘇達大學的研究者們提出了該領域新的任務:針對長視頻生成簡介����、連貫的描述性故事。為此���,他們建立了新的數(shù)據(jù)集并提出了新的模型�����。在該數(shù)據(jù)集上��,他們將新模型與前人工作中效果最佳的模型進行了比較�����,新模型取得了更優(yōu)的結(jié)果�。

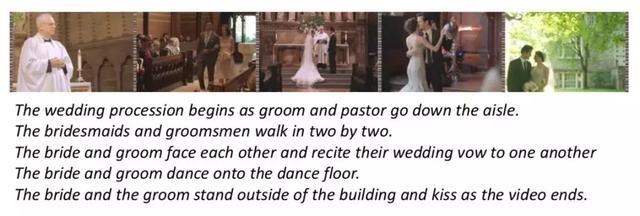

圖|上圖為人類所寫的故事; 下圖為新模型生成的故事����; 均只選擇了故事的前五句和視頻中它們nm相應的關鍵幀的采樣。

針對長視頻生成故事這一新任務與以往的各項任務都存在著顯著的差別��。與短視頻詳細描述任務相比����,該任務更關注包含復雜動態(tài)事件的長視頻�����,抽取其中的重要場景生成故事���,而不要求包含視頻中出現(xiàn)的每一個細節(jié)。而與根據(jù)照片流生成故事相比�����,該任務更基于視覺內(nèi)容。因為由照片流生成故事的任務中�,視覺材料由一張張照片組成,相對貧乏�����,故而任務的關鍵是填補照片中間的信息鴻溝���。這就意味著故事講述的過程需要想象力和先驗知識���,得到的故事可能因為標注者的背景不同而產(chǎn)生很大差異。而這項任務的視覺信息十分充足��,根據(jù)視覺信息就足以生成故事�,不會受到過多主觀因素的影響。

基于這些特性����,這項新任務也主要面臨兩大挑戰(zhàn)。第一�����,與單句描述相比,長故事包含數(shù)量更多����,更多樣化的句子。而對于相同的視覺內(nèi)容���,可能有多種多樣的描述�����。為此����,保證故事的簡潔性和連續(xù)性就更為困難�����。第二�����,長視頻中通常包含多個角色�����、地點和活動�����,難以把握故事的主線�����。

為了應對這些挑戰(zhàn)�,研究者將該任務分解為兩個子任務。首先從長視頻中挖掘重要的片段�����,然后通過檢索的方式選擇合適的句子生成故事����。根據(jù)這兩個子任務,他們提出了由兩個部分組成的模型��。

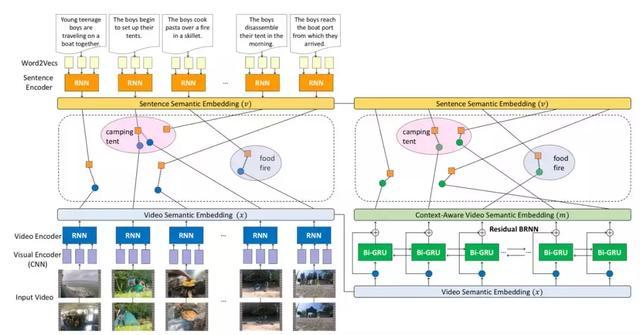

模型的第一部分是上下文感知多模態(tài)嵌入學習框架��,通過兩個步驟����,由局部到全局建立起多模態(tài)語意空間����,也就是將視頻內(nèi)容和自然語言映射到同一語意空間中�,將其聯(lián)系在一起。它首先對視頻片段-句子對進行建模���,然后將長視頻轉(zhuǎn)化為一系列的視頻片段���。通過一個殘差雙向 RNN(Residual Bidirectional RNN)進行處理。該結(jié)構(gòu)不僅能將上下文信息整合到多模態(tài)語意空間中��,同時可以保證時序上的連貫性和語意嵌入的多樣性��。

圖|局部到整體的多模態(tài)嵌入式學習模型����。左側(cè)部分為局部嵌入學習。針對每一個輸入的視頻片段-句子對����,利用 CNN+RNN 對視頻片段進行編碼,利用 RNN 對句子進行編碼���。

右側(cè)為全局嵌入學習����,將視頻片段和句子應映射到同一語意空間��。

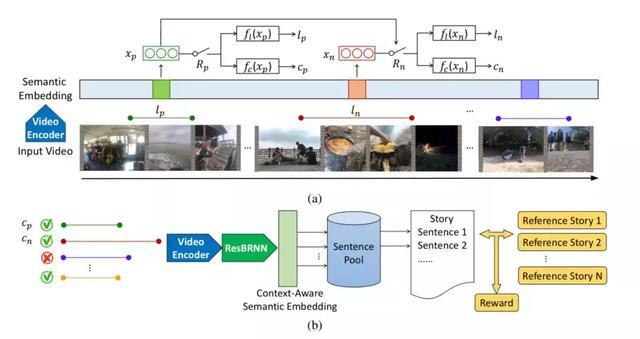

模型的第二部分稱之為“旁白”�。給定一個視頻,該結(jié)構(gòu)首先從中抽取一系列重要的剪輯片段���,接下來在語意空間中檢索與這些剪輯片段最匹配的句子�,生成整個故事����。視頻中哪些方面對于一個好故事是重要的呢?換句話說����,什么樣的片段是重要的呢?這顯然沒有一個明確的定義����。因此,這一模塊被設計為一個強化學習的代理����,通過觀察一系列的輸入視頻來學習一個策略���,通過該策略選擇獎勵最大的剪輯片段。而這個獎勵�����,就是通過這些剪輯片段生成的故事與人類書寫的參考故事之間的相似度來決定�。

圖|上圖為旁白網(wǎng)絡,根據(jù)輸入的視頻提取重要的視頻片段�����。下圖為根據(jù)提取出的片段檢索出句子組合成故事的過程����。

數(shù)據(jù)集一直是驅(qū)動該領域研究進步的重要因素